Meta 发布了 Llama 3.2 模型,这是一个具有增强功能、更广泛适用性和多模态图像支持的突破性语言模型系列,现在可在 Amazon Bedrock 中使用。此版本代表了大型语言模型 (LLM) 的重大进步,可在各种用例中提供增强的功能和更广泛的适用性。

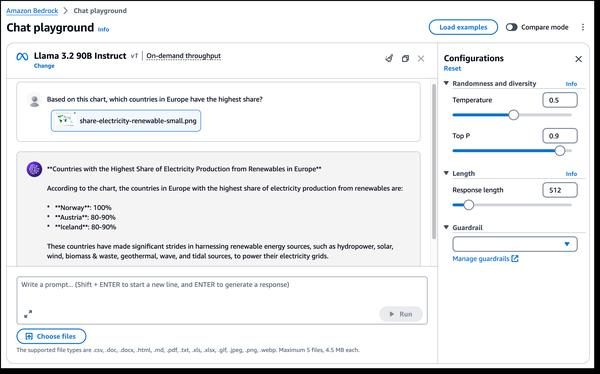

Llama 3.2 最令人兴奋的方面之一是引入了多模态视觉功能。新的 90B 和 11B 模型专为图像理解和视觉推理而设计,为图像字幕、图像文本检索和视觉问答等应用开辟了新的可能性。这些功能可能会彻底改变我们在不同领域与图像交互和利用图像的方式。

此外,Llama 3.2 还提供适用于边缘设备的轻量级模型。1B 和 3B 模型旨在通过减少延迟和提高性能来提高资源效率,使其成为功能有限的设备上应用程序的理想选择。这可能会导致在移动设备上开发更智能的 AI 驱动的写作助手和客户服务应用程序。

此外,Llama 3.2 建立在 Llama Stack 之上,Llama Stack 是一个用于构建规范工具链组件和代理应用程序的标准化接口,使构建和部署比以往任何时候都更容易。这为开发人员提供了一种标准化且高效的方式来将 Llama 模型集成到他们的应用程序中。

总的来说,Llama 3.2 的发布标志着大型语言模型领域的重大进步。其增强的功能和更广泛的适用性为从图像理解和视觉推理到边缘应用程序的广泛用例开辟了新的可能性。随着生成式 AI 技术的不断发展,我们可以预期 Llama 3.2 等模型将带来更多创新和变革性应用。