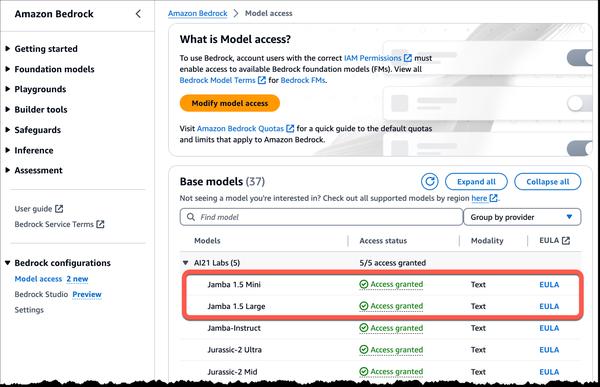

AWS 和 AI21 Labs 宣布在 Amazon Bedrock 中推出 AI21 Labs 功能强大的全新 Jamba 1.5 系列大型语言模型 (LLM)。这些模型代表了长上下文语言能力的重大进步,可在各种应用程序中提供速度、效率和性能。

Jamba 1.5 模型利用独特的混合架构,将 Transformer 模型架构与结构化状态空间模型 (SSM) 技术相结合。这种创新方法使 Jamba 1.5 模型能够处理长达 256K 个标记的长上下文窗口,同时保持传统 Transformer 模型的高性能特征。

Jamba 1.5 模型的一些主要优势包括:

* 长上下文处理:凭借 256K 个标记的上下文长度,Jamba 1.5 模型可以提高企业应用程序的质量,例如冗长的文档摘要和分析,以及代理和 RAG 工作流程。

* 多语言:支持英语、西班牙语、法语、葡萄牙语、意大利语、荷兰语、德语、阿拉伯语和希伯来语。

* 对开发人员友好:原生支持结构化 JSON 输出、函数调用,并且能够消化文档对象。

* 速度和效率:AI21 测量了 Jamba 1.5 模型的性能,并分享了这些模型在长上下文上的推理速度比同等规模的其他模型快 2.5 倍。

Jamba 1.5 模型非常适合配对文档分析、合规性分析和长文档问答等用例。它们可以轻松比较来自多个来源的信息,检查段落是否符合特定指南,以及处理非常长或复杂的文档。

AI21 Labs 的 Jamba 1.5 模型系列现已在 AWS 美国东部(弗吉尼亚北部)区域的 Amazon Bedrock 中全面上市。

我相信这些模型代表了语言处理领域的重大进步。处理长上下文的能力为开发人员和企业开辟了广泛的新可能性。我很高兴看到使用这些模型开发出哪些创新应用程序。