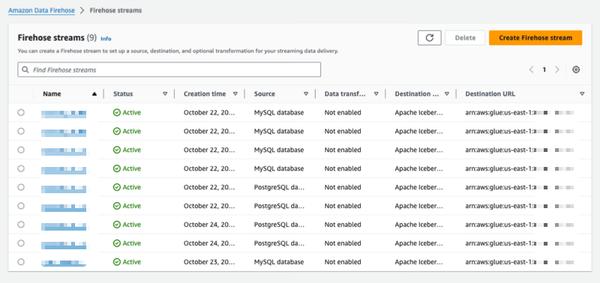

Amazon Data Firehose 推出了一项新功能,可以捕获 PostgreSQL 和 MySQL 等数据库中的更改,并将更新复制到 Amazon S3 上的 Apache Iceberg 表中。这提供了一个简单的端到端解决方案,用于流式传输数据库更新,而不会影响事务性能。用户可以在几分钟内设置 Data Firehose 流,以从其数据库传递变更数据捕获 (CDC) 更新。现在,他们可以轻松地将数据从不同的数据库复制到 Amazon S3 上的 Iceberg 表中,并将最新数据用于大规模分析和机器学习 (ML) 应用程序。AWS 企业客户通常将数百个数据库用于事务应用程序。为了对最新数据执行大规模分析和 ML,他们希望捕获数据库中所做的更改,例如在表中插入、修改或删除记录时,并将更新以 Apache Iceberg 等开源表格式交付到其数据仓库或 Amazon S3 数据湖中。许多客户开发提取、转换和加载 (ETL) 作业来定期从数据库读取数据。但是,ETL 读取器会影响数据库事务性能,并且批处理作业可能会在数据可用于分析之前增加数小时的延迟。为了缓解这种情况,客户希望流式传输数据库中所做的更改,这称为 CDC 流。借助这项新的数据流功能,Data Firehose 增加了从数据库获取 CDC 流并将其连续复制到 Amazon S3 上的 Apache Iceberg 表中的能力。用户通过指定源和目标来设置 Data Firehose 流。Data Firehose 捕获初始数据快照并将所选数据库表的所有后续更改作为数据流进行复制。为了获取 CDC 流,Data Firehose 使用数据库复制日志,从而减少对数据库事务性能的影响。当数据库更新量波动时,Data Firehose 会自动对数据进行分区,并在交付之前保留记录。用户无需预置容量或管理集群。Data Firehose 还可以在初始流创建期间使用与数据库表相同的架构自动创建 Apache Iceberg 表,并根据源架构更改自动演化目标架构。作为一项完全托管的服务,Data Firehose 消除了对开源组件、软件更新或运营开销的需求。

使用 Amazon Data Firehose 将数据库中的更改复制到 Apache Iceberg 表中(预览版)

AWS