Amazon Bedrock 宣布了新的 RAG 评估和 LLM-as-a-judge 功能,简化了生成式 AI 应用程序的测试和改进。Amazon Bedrock 知识库现在支持 RAG 评估,允许您运行自动知识库评估来评估和优化检索增强生成 (RAG) 应用程序。这使用大型语言模型 (LLM) 来计算评估指标,从而能够比较不同的配置并进行调整以获得最佳结果。Amazon Bedrock 模型评估现在包括 LLM-as-a-judge,允许以人工评估成本和时间的一小部分对其他模型进行人工质量的测试和评估。这些功能可提供快速、自动化的 AI 应用程序评估,缩短反馈循环并加快改进速度。评估会评估质量维度,例如正确性、有用性以及负责任的 AI 标准(例如答案拒绝和有害性)。结果会为每个分数提供自然语言解释,并将其从 0 标准化为 1 以便于理解。文档中发布了标题和评判提示以提高透明度。

Amazon Bedrock 中新的 RAG 评估和 LLM-as-a-judge 功能

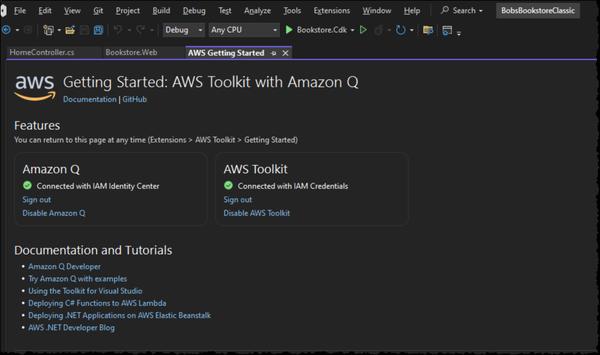

AWS